„ Sehr gute Beratung bei der Konzeption unserer App. " Ayse

„ Sehr gute Beratung bei der Konzeption unserer App. " Ayse

Zur Jahrtausendwende befürchteten viele Menschen, dass es zu einem großflächigen Ausfall der damals vorhandenen IT-Infrastruktur kommen könnte. Ein großer Teil dieser Befürchtungen war reiner Aberglaube, doch gab es den sogenannten Millenium-Bug, der tatsächlich für einige Probleme sorgte, vor allem bei Geräten und Systemen, die in irgendeiner Weise auf eine Datumsanzeige setzten.

Im Jahre 2038 wird es wieder einen solchen Moment geben, in dem durch fehlerhafte Datumsanzeigen schwerwiegende Probleme auftreten könnten, denn am 19. Januar 2038 um 03:14:07 Uhr UTC läuft zwar nicht der Maya-Kalender ab, sondern die sogenannte Unixzeit.

Die sogenannte Unixzeit ist eine Zeitdefinition, die in den 70er Jahren für das Betriebssystem Unix eingeführt wurde. In der aktuell gültigen Definition von 1975 begann die Unixzeit am 1. Januar 1970, 00:00:00 Uhr UTC (UTC = Coordinated Universal Time = koordinierte Weltzeit). Sie zählt dabei die vergangenen Sekunden seit dem Startdatum, wobei Schaltsekunden übersprungen werden.

Die Unixzeit hat insgesamt eine Kapazität von 2.147.483.647 Sekunden, was einer vorzeichenbehaftete 32-Bit-Ganzzahl entspricht (231 – 1). Sobald diese überschritten wird (was im Jahre 2038 der Fall sein wird), springt das Vorzeichen von positiv auf negativ um, was zu einer Zeitangabe weit vor dem 1. Januar 1970 bedeuten würde.

Hier ist das die Krux des Jahr-2038-Promblems zu erkennen. Sämtliche Systeme, die diese 32-Bit-Unixzeit verwenden, werden ab diesem Zeitpunkt ein völlig falsches Datum anzeigen und verarbeiten. In der Softwareentwicklung nennt man dieses Problem auch Zählerüberlauf.

Da Unixsysteme vor allem bei Banken und ihm Versicherungssektor eine weite Verbreitung besitzen, sind diese Wirtschaftszweige natürlich besonders gefährdet, vor allem, da diese Branchen stark auf korrekte Zeitstempel angewiesen sind. Neben diesen Servern und anderen Unixsystemen arbeiten viele eingebettete Systeme (z.B. Router oder elektronische Messgeräte) mit unixartigen Betriebssystemen.

Gravierend könnten die wirtschaftlichen Schäden werden, wenn beispielsweise Transaktionen von Banken nicht getätigt werden, weil sie weiterhin auf den direkten Zeitstempel warten. Der würde allerdings länger auf sich warten lassen, da die Unixzeit fälschlicherweise einen Zeitpunkt im Dezember 1901 angeben würde.

Für die Anwender von unixbasierten Betriebssystemen oder Programmen könnte sich das Jahr-2038-Problem dadurch äußern, dass die Software in eine Endlosschleife gerät und sich dadurch „aufhängt“, da die Programme auf einen gewissen (scheinbar weit in der Zukunft liegenden) Zeitpunkt warten.

Sollte das Problem mit der ablaufenden Unixzeit also nicht rechtzeitig behoben werden, drohen in vielen wirtschaftlichen Bereichen, in den mitunter extrem viel Geld steckt, enorme wirtschaftliche Schäden und Systemtotalausfälle.

Um diesem Problem zu beheben und um eine Wiederholung der Folgen wie beim Millenium-Bug von 2000 zu verhindern, bei dem durch ungenügende Vorbereitung ein ähnlicher Fehler in der Verarbeitung von Jahreszahlen zu wirtschaftlichen Schäden im Bereich von mehreren hundert Milliarden US-Dollar eintraten, werden schon weit im Voraus Vorkehrungen getroffen, um die Schäden zu minimieren oder komplett auszuschließen.

Grundlegend wird die Unixzeit von 32-Bit auf 64-Bit umgestellt, was dazu führen würde, dass die dann neu definierte Unixzeit erst in 292 Milliarden Jahren auslaufen würde. Zum Vergleich: Das Universum ist bisher circa 13,81 Milliarden Jahre alt. Bis das der Fall sein wird, bleibt der Menschheit also noch genug Zeit, um eine technische Lösung für dieses Problem zu finden.

Diese Umstellung ist bereits im Gange und wird sukzessive mit neuen Unixupdates auf die verschiedensten Systeme aufgespielt. Allerdings ist damit das Problem nicht endgültig gelöst oder Schäden abgewandt, da dadurch zwar die Server eine 64-Bit-Unixzeit liefern, die Programme, die noch mit 32-Bit arbeiten diese allerdings nicht verarbeiten können, was erneut zum Jahr-2038-Problem führt. Es müssen also auch sämtliche Programme, die die Unixzeit vernwenden, auf 64-Bit aufgerüstet werden.

Diese Umstellung kann mitunter sehr aufwendig sein, da der komplette Programmcode vieler und komplexer Programme durchforstet und aktualisiert werden muss.

Eine Alternative zur Umstellung auf eine 64-Bit Unixzeit mit Sekundenschritten stellt eine Verkleinerung der Zeitintervalle dar, wie sie so bereits in vielen Entwicklungsumgebungen wie bei JAVA (64-Bit und Millisekunden) eingesetzt werden. Da gerade im Bankensektor eine so hohe zeitliche Genauigkeit von Nöten ist, scheint es sinnvoll, die Unixzeit auch in dieser Hinsicht zu überarbeiten.

Eine weitere Möglichkeit wäre es, den Zeitstempel als Zeichenkette (YYYYMMDDHHMMSS) abzuspeichern, wie es in ISO 8601 bereits vorgesehen ist. Dies würde bis zum Jahreswechsel 9999/10000 ausreichen, um Jahr-Überlauf-Probleme auszuschließen. Allerdings müssten auch hier etliche Programme angepasst werden, da innerhalb eines Programms der Zeitstemepl wieder in ein problematisches Binärformat umgewandelt werden könnten.

Das bereits erwähnte Jahr-2000-Problem (oder Millenium Bug) verursachte zum Jahrtausendwechsel enorme wirtschaftliche Schäden und sorgte sogar für eine Rezession in der Informatikbranche.

Zehn Jahre später, im Jahr 2010 traten einige der für das Jahr 2000 erwarteten Fehler unerwartet auf und überraschte die Wirtschaft. So wurden durch fehlerhafte Datumsformate vor allem bei EC- und Kreditkarten die Jahre 2010 und 2016 vertauscht.

Beim Jahr-2027-Problem werden auf Rechnern der 3000er Serie des Herstellers Hewlett-Packard die Bits für das Datenformat aufgebraucht sein. Da diese Rechner allerdings seit 2015 keinen Support mehr erfahren und bereits mehrere Jahrzehnte alt sind, sind hier keine nennenswerten Schäden zu erwarten.

Im Jahr 2036 werden die Zähler des in Unix-Kreisen weit verbreiteten Zeitsynchronisations-Protokolls NTP (Network Time Protocol) überlaufen, was vor allem für eingebettete Systeme wie Router oder Messgeräte problematisch werden könnte. Diesem Problem wurde allerdings bereits weitestgehend durch moderne Implementierungen entgegengewirkt.

Auch wenn es auf den ersten Blick erschreckend wirken mag, dass die Zeit so vieler Server und Rechner in der Wirtschaft auszulaufen droht, kann an dieser Stelle weitestgehend Entwarnung gegeben werden. Größere Ausfälle oder finanzielle Schäden sind nicht zu erwarten, da bereits Jahrzehnte im Voraus geplant wurde. Lediglich in einzelnen oder veralteten Systemen könnte es zu kleineren Problemen kommen.

Auch wenn bis zum Jahr 2038 noch einige Jahre ins Land gehen werden, treten immer wieder (zum Glück meist weniger schwerwiegende) Probleme mit PCs, Laptops oder anderer Hardware auf. Sollten Sie ein solches Problem haben, wenden sie sich gerne vertrauensvoll an uns! Unsere zertifizierten IT-Spezialisten kümmern sich um alle Arten von PC-Problemen und bieten eine Reihe an Dienstleistungen an:

Kontaktieren Sie uns ganz einfach rund um die Uhr per:

Wir freuen uns auf Ihre Kontaktaufnahme!

Im ersten Teil unseres Artikels zum Thema Cloud-Computing haben wir bereits die verschiedenen Arten von Clouds und deren technische Realisierung gesprochen. Im heutigen Beitrag soll es um die Vor- und Nachteile und rechtliche Fragen, die bei der Nutzung solcher Dienste auftreten, gehen.

Wie in unserem Artikel zum Thema Datensicherheit und Datenschutz näher erklärt, ist in rechtlicher Hinsicht zu beachten, dass ein vollständiger und den gesetzlichen Richtlinien entsprechender Datenschutz nur durch eine technisch vollständig erfüllte Datensicherheit erreicht werden kann.

Da in Deutschland (beziehungsweise allgemeiner in der Europäischen Union) ein weitaus strikterer Datenschutz gilt als es in den USA der Fall ist, ist der Datenschutz für Cloud-Dienstleister und deren Nutzer ein heikles und teils unübersichtliches Thema. Denn gut 90 % aller Cloud-Rechenzentren stehen in den Vereinigten Staaten.

Damit unterstehen die Dienstleister (wie zum Beispiel Google, Apple oder Amazon) dem amerikanischen Recht und damit dem sogenannten Patriot Act. Dieser besagt, dass die Firmen auch personenbezogene Daten an staatliche Behörden (beispielsweise die NSA) weitergeben müssen. Ein Datenschutz nach deutschem beziehungsweise europäischen Recht ist damit nicht gewährleistet und kann unter Umständen zu Bußgeldern für die Kunden von Cloud-Anbietern führen, wenn personenbezogene Daten der Nutzer über den Clouddienstleister an amerikanische Behörden weitergegeben werden.

Ebenfalls zu beachten ist das Urheberrecht beim Speichern von urheberrechtlich geschützten Medien in einer Cloud. Prinzipiell stellt dieses Speichern eine Vervielfältigung dar und ist damit rechtswidrig, solange die Erlaubnis des Urhebers nicht eingeholt wurde und die Daten nicht für rein private Nutzen gespeichert werden.

Um den genannten rechtlichen Problemen entgegenzutreten hat sich im Jahr 2010 die Institution cloud services made in Germany gegründet, die ihre Dienste in Einklang mit geltendem deutschen Recht anbieten. Diese umfassen nicht nur CRM-Systeme, sondern auch Lösungen für Zeiterfassung, Terminverwaltung oder Personaleinsatzplanung. Die Server dieser Anbieter stehen in Deutschland und es wird die DSGVO und das deutsche Datenschutzgesetz angewandt.

Zu den großen Vorteilen des Cloud-Computings gehört sicherlich, dass sich die benötigte Hardware stark in Grenzen hält, da letztlich nur ein Endgerät von Nöten ist und nicht die gesamte Serverstruktur. Außerdem kann in den meisten Fällen von fast überall her über das Internet auf die Daten oder die Anwendungen in der Cloud zugegriffen werden – das zu jeder Tages- und Nachtzeit.

Einhergehend mit der Online-Speicherung geht auch die Sicherheit vor Datenverlust. Werden die Daten lokal gespeichert, besteht immer die Gefahr, dass die Daten bei einer Beschädigung des Speichermediums verloren gehen. Um dieses Manko auszugleichen müssten Konzepte zur Datensicherung und für Backups angewandt werden, welche bei einer Cloud-Lösung meistens vom Dienstleister mit angeboten werden. Man muss ich also auch um solche alltäglichen Probleme nicht kümmern.

Weiterhin sind bei den meisten Cloud-Lösungen keinerlei Softwareinstallationen auf dem lokalen Rechner nötig. Damit entfallen natürlich auch Wartungsarbeiten, Updates und dergleichen. Diese Dinge werden ebenfalls vom Dienstleister übernommen.

Ob sich eine Cloud für ein Unternehmen rentiert, ist ein Rechenspiel. Man muss die Kosten für den Dienstleister gegenüber dem Kauf (oder der Mietung) der Hardware abwägen und weiterhin beachten, dass auch Wartung und Instandhaltung nicht nur mit Arbeitskraft, sondern auch mit Arbeitszeit und damit Geld verbunden ist. Außerdem kann man sich bei einer Cloud-Lösung zumindest für diesen Bereich Personal einsparen.

Neben den großen Vorteilen gibt es aber auch eine Reihe an klaren Nachteilen, die nicht zu unterschätzen sind. So ist ganz grundlegend: Kein Internet, keine Arbeit. Sollte also die Internetverbindung unterbrochen sein, kann auch kein Zugriff auf die Cloud und damit auf die Dateien und die Anwendungen erfolgen. Seitens der Dienstanbieter wird in den allermeisten Fällen technisch für einen Stromausfall oder dergleichen vorgesorgt, doch hat der Kunde kein Internet, liegt die Arbeit unter Umständen brach.

Ein weiterer Nachteil in Bezug auf das Internet ist, dass der Kunde auch eine erhebliche Bandbreite benötigt, um die Daten und Anwendungen vernünftig nutzen zu können. Da selbst einfache Arbeiten wie das Erstellen einer PowerPoint-Präsentation über das Internet abgewickelt werden, wird der Kunde in hohem Maße vom Internetdienstleister abhängig.

Wie bereits erwähnt stehen die meisten Server von Cloudanbietern wie Amazon oder Google in den USA. Durch den sogenannten Patriot Act sind diese amerikanischen Firmen dazu verpflichtet, Daten ihrer Kunden an die US-Regierung weiterzugeben, selbst wenn diese auf Servern gespeichert sind, die gar nicht auf amerikanischem Territorium stehen. Das bedeutet, dass alle Daten, auf Hardware von amerikanischen Firmen gespeichert werden, an die amerikanische. Regierung weitergeleitet werden dürfen (nach amerikanischem Recht), selbst wenn der fragliche Server in Frankfurt oder München steht. Der Serverstandort ist also kein Garant dafür, dass das geltende Recht des Standortlandes auch angewandt wird. Inwieweit dies für Industriespionage ausgenutzt wird, bleibt den Kunden verborgen und gerade Firmenkunden sind gut beraten, sich dieser Tatsache bewusst zu sein.

Durch die dauerhafte Anbindung an externe Hardware über das Internet erhöht sich zwangsläufig auch die Gefahr durch Hackerangriffe und andere Angriffe über das Internet. Dieses Risiko erhöht sich in manchen Belangen unnötigerweise, da einige Anwendungen, die bei einer Cloud-Lösung über das Internet laufen, prinzipiell auch ohne diese Schnittstelle möglich wären.

Gerade für kleine Unternehmen stellt sich an einem gewissen Punkt der Firmenentwicklung die Frage, ob sie auf eine Cloud-Lösung setzen oder doch eher „offline“ arbeiten wollen. Gerade wenn eine Firma bereits mehrere Standorte hat werden die Vorteile einer Cloudlösung immer schwerwiegender, da so die einzelnen Mitarbeiter unterschiedlicher Büros sehr leicht miteinander zusammenarbeiten können.

Hat die Firma allerdings nur einen Firmensitz, stellt sich die Frage, ob ein eigenes, lokales Severnetzwerk eventuell eine bessere Lösung darstellt. Man muss dabei immer abwägen, was die jeweiligen Anforderungen an ein Firmennetzwerk sind und welche Lösung am sinnvollsten ist. Geht es ausschließlich um den Austausch von Daten, ist ein eigener Server ratsam, sollen aber auch Softwareanwendungen dezentral (also nicht auf dem lokalen Rechner der Nutzer) verwendet werden, kommt man kaum um eine Cloud herum.

Ob eine Cloud-Lösung für eine Firma (oder Privatpersonen) sinnvoll ist, muss die jeweilige Institution natürlich selbst abwägen. Kosten und Nutzen, Sicherheitsfragen, Abhängigkeiten und die dezentrale Abwicklung von Abläufen und Geschäften müssen überdacht und eventuell sogar angepasst werden. Trotz gewisser Risiken und Gefahren birgt eine Cloud-Lösung aber vor allem für kleine und mittelständische einige Vorteile, die mitunter wirtschaftlich entscheidend sein können.

Als Münchner IT-Dienstleister sind wir auch Spzialisten für Cloud-Lösungen und bieten Problembehandlung für diesen Bereich an. Unsere qualifizierten IT-Spezialisten helfen Ihnen gerne bei Ihren Problemen weiter! Folgende Bereiche gehören zu unserem Leistungsportfolio:

Vereinbaren Sie mit uns unverbindlich ein erstes Beratungsgespräch. Gerne können Sie uns eine Anfrage per E-Mail an Diese E-Mail-Adresse ist vor Spambots geschützt! Zur Anzeige muss JavaScript eingeschaltet sein! senden oder uns jederzeit unter der Rufnummer 0176 / 75 19 18 18 erreichen. Wir freuen uns auf Ihre Kontaktaufnahme!

Über den Begriff Cloud stolpert man immer häufiger, vor allem, da mittlerweile so ziemlich jede Internetfirma eine eigene solche Plattform anbietet. Angefangen bei Google über Microsoft bis hin zu Amazon und Apple gibt es zig verschiedene Lösungen, mit denen man arbeiten kann. Aber was genau ist denn nun so eine Cloud? Welche Varianten gibt es? Wie funktionieren sie? Und ist es besser offline zu arbeiten oder doch lieber offline? Im ersten Teil dieser Artikelreihe klären wir zunächst, was eine Cloud ist, welche Typen es gibt, wie sie aufgebaut ist und welche Bedeutung sie in der heutigen Wirtschaftswelt hat.

Was ist eine Cloud?

Eine Cloud ist eine IT-Infrastruktur, die meist über das Internet angeboten wird und in der Speicherplatz, Rechenleistung und Anwendungen als Dienstleistung angeboten werden. Dies bedeutet aus technischer Sicht in erster Linie, dass die Arbeitsprozesse nicht an einem lokalen Rechner beim Anwender vor Ort ablaufen, sondern auf der Hardware des Anbieters. Somit entfallen für den Benutzer die Softwareinstallation und das verwendete Endgerät benötigt unter Umständen bei weitem weniger Rechenleistung und ist damit kostengünstiger.

Viele Anbieter (wie beispielsweise Google mit Google Drive) bieten für Privatnutzer in erster Linie Cloudspeicher an. Hiermit können persönliche Dateien wie Bilder, Dokumente oder Sounddateien in der Cloud gespeichert werden. Das Prinzip des Cloud-Computings geht allerdings weit über diese reine Speicherplatzauslagerung hinaus.

Google bietet beispielsweise die Möglichkeit an, die Dateien direkt im Browser (und damit ohne einen vorherigen Download) zu bearbeiten. Diese Webanwendungen bieten häufig ähnlich umfangreiche Möglichkeiten wie ihre auf dem Rechner installierten Pendants.

Im großen Maße dienen Clouds allerdings der Zusammenarbeit sehr vieler Menschen (zum Beispiel in einem Unternehmen), ohne dass jeder einzelne die Software auf seinem Rechner installiert haben muss.

Welche Arten von Clouds gibt es und was unterscheidet sie?

Nach der Definition des amerikanischen National Institute of Standards and Technology (NIST) gibt es drei verschiedene Servicemodelle und vier Liefermodelle.

Servicemodelle

Liefermodelle

Die Unterschiede zwischen den einzelnen Varianten der Clouds liegen also in erster Linie in der Art der Bereitstellung und der Art und Weise, wie die Dienste in Anspruch genommen, bezahlt und verwaltet werden können.

Technische Realisierung – Wie ist eine Cloud aufgebaut?

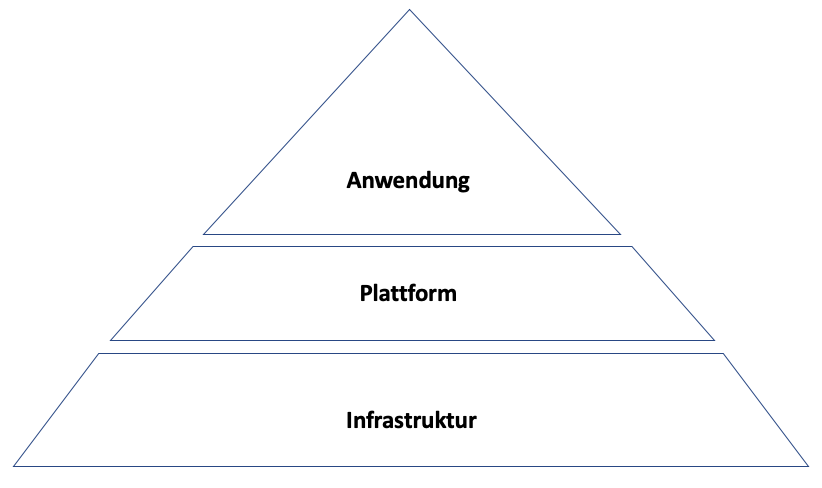

Die bereits weiter oben beschriebenen drei Servicemodelle des Cloud-Computing stellen gleichzeitig eine grundlegende Möglichkeit dar, eine Cloud technisch zu organisieren. Man muss sich eine Cloud also als dreiteilige Pyramide vorstellen, in der höhere Ebenen auf den unteren aufbauen, aber nicht unbedingt vorhanden sein müssen.

So basiert jede Cloud selbstverständlich auf der Hardware-Infrastruktur (unterste Ebene). Ein Vorteil der Arbeit auf dieser Ebene ist, dass die Recheninstanzen je nach Anforderung mehr oder weniger beliebig skaliert oder um weitere Instanzen erweitert werden können. Dabei hat der Benutzer vollständigen Zugriff auf die verschiedenen Instanzen und ist ab der Ebene des Betriebssystems selbst dafür verantwortlich.

Die zweite Ebene der Cloud Pyramide besteht aus der Plattform. Der Unterschied zur Infrastruktur-Ebene liegt darin, dass der Nutzer keinen direkten Zugriff mehr auf die Recheninstanzen hat, sondern nur innerhalb des gesteckten Rahmens sämtliche Einheiten und Unterteilungen verwaltet. Daraus folgt, dass der Cloud-Dienstleister die tatsächlich arbeitenden Instanzen nach Belieben vergrößern oder erweitern kann. Für den Kunden ist diese Abstraktion der technischen Komponente von Vorteil, wenn die Benutzer der Cloud lediglich Daten verarbeiten und nicht die technische Basis an sich administrieren sollen.

Die oberste Ebene der Pyramide stellen die Anwendungen (also die Software) dar. Auf dieser Ebene muss sich der Nutzer weder um die technischen Komponenten noch um die Skalierbarkeit des Systems kümmern. In erster Linie dient diese Ebene der Anwendung von Software durch den jeweiligen Nutzer. Diese Form der Cloud ist die unter Privatanwendern am weitesten verbreitete. Bekannte Beispiele sind Google Drive, Microsoft OneDrive oder Apple iCloud.

Cloud-Computing in der Wirtschaft

Vor allem in der Wirtschaft ist das Cloud-Computing mittlerweile stark verankert. Sie bieten großen Unternehmen weitreichende Möglichkeiten sich zu vernetzen und ihre Arbeitsabläufe den heutigen Anforderungen anzupassen. In erster Linie spart man eine Menge Kosten ein, da lokal weitaus weniger Soft- und Hardware von Nöten sind, wenn man mit einer Cloud-Lösung arbeitet.

Ein weiterer Vorteil der abstrahierten Infrastruktur einer Cloud ist, dass man Leistungsspitzen durch das dynamische Hinzuschalten von Rechenleistung leichter ausgleichen kann als mit herkömmlichen Systemen, bei denen immer genug Kapazität vorhanden sein muss, selbst wenn diese gerade nicht benötigt wird. Dadurch, dass nicht durchgängig diese Infrastruktur bereitgehalten werden muss, kann ein Unternehmen enorme Kosten einsparen.

Problematisch bei Cloud-Anwendungen ist in erster Linie die Sicherheit der Daten bei der Übertragung über das Internet. Hier hat die Weiterentwicklung der Verschlüsselungstechnologie, Probleme behoben, allerdings bestehen nach wie vor Risiken. Weiterhin ist zu beachten, dass es in vielen Fällen keine eindeutige Lösung für den Fall gibt, dass der Cloud-Anbieter oder ein beteiligter Dienstleister insolvent gehen. Was passiert dann mit den Daten? Sind sie verloren oder können sie noch gesichert werden? Manche Dienstleister bieten für solch einen Fall bereits eine Datenrücksicherung an.

Ein anderer großer, wenn auch nicht technischer, Nachteil ist, dass sich ein Unternehmen mit der Nutzung einer Cloud von dessen Anbieter abhängig macht. Nicht nur die bereits erwähnte Frage, was bei einer Insolvenz eines Anbieters geschieht, sondern auch die Tatsache, dass die Softwarehersteller durch die Endbenutzer-Lizenzvereinbarungen die Zugangsberechtigung zur Software jederzeit entziehen können. Dadurch sind die Kunden diesen Unternehmen schutzlos ausgeliefert. Solch ein Fall wurde beispielsweise 2018 publik, als Adobe kurzerhand die Lizenzen älterer Software aus ihrer Cloud als ungültig erklärte und mit rechtlichen Maßnahmen drohte, sollte man die Software weiterhin verwenden.

Im zweiten Teil dieses Artikels gehen wir näher auf rechtliche Fragen, die Vor- und Nachteile von Cloud-Computing ein und vergleichen diese moderne Arbeitsform mit der klassischen Arbeit „offline“.

Sie suchen einen zuverlässigen IT-Spezialisten für Cloud-Computing?

Als IT-Dienstleister in München bieten wir Ihnen eine Top-Beratung im Bereich Cloudanwendungen und -computing an. Wir helfen Ihnen ihre eigene Cloud-Infrastruktur aufzubauen, zu erneuern, erweitern oder zu warten. Gerne besprechen wir mit Ihnen die Unternehmenslösungen die für sie in Frage kommen. Folgende Bereiche gehören zu unserem Leistungsportfolio:

Vereinbaren Sie mit uns unverbindlich ein erstes Beratungsgespräch. Gerne können Sie uns eine Anfrage per E-Mail an Diese E-Mail-Adresse ist vor Spambots geschützt! Zur Anzeige muss JavaScript eingeschaltet sein! senden oder uns jederzeit unter der Rufnummer 0176 / 75 19 18 18 erreichen. Wir freuen uns auf Ihre Kontaktaufnahme!

Keine moderne Firma und die wenigsten heutigen Haushalte kommen noch ohne einen Drucker oder ein Multifuktionsgerät mit Kopierer und Scanner aus. Da mit den Jahren die Preise für privat nutzbare Drucker immer weiter gefallen sind, kann sich jeder einen Drucker für daheim leisten und seine Dokumente oder die Bilder vom letzten Urlaub selbst ausdrucken.

Im allgemeinen Sprachgebrauch werden meist Tintenstrahldrucker und Laserdrucker verwendet. Sie sind gleichzeitig die im privaten Bereich am meisten verbreiteten Druckertypen. Im Folgenden erklären wir die Unterschiede, Vor- und Nachteile sowie die Funktionsweise dieser beiden Druckervarianten.

Der Tintenstrahldrucker – ein Klassiker und günstig zu haben

Mittlerweile gibt ein breites Angebot an Tintenstrahldruckern, die weit unter 100 Euro kosten. Grundsätzlich sind hier noch einmal die CIJ-Drucker (Continuous Ink Jet = Tintenstrahldrucker) und die DOD-Drucker (Drop on Demand, Tintendrucker) zu unterscheiden.

Continuous Ink Jet (Tintenstrahldrucker)

Bei dieser Bauweise wird ein durchgängiger Tintenstrahl aus der Drüse des Druckkopfes abgesondert. Durch einen piezoelektrischen Wandler wird der Strahl so beeinflusst, dass er gleichmäßig in Tropfen zerfällt. Durch eine Ladeelektrode werden die dadurch entstandenen Tropfen elektrostatisch aufgeladen, sodass dann mittels einer Ablenkelektrode je nach angelegter Spannung unterschiedlich stark abgelenkt werden können, wodurch sich das Druckbild ergibt.

Nicht benötigte Tropfen werden bereits im Druckkopf abgefangen und zurück in den Tintenspeicher geführt, sodass keine Tinte verschwendet wird oder unerwünschte Tropfen auf das Papier gelangen.

Drop on Demand (Tintendrucker)

Dieser Druckertyp findet in einem sehr weit gefächerten Bereich Anwendung. Von Passbildern über den Bürobereich bis hin zur industriellen Nutzung werden die verschiedensten Bereiche abgedeckt. Neben Tinte können bestimmte Geräte mit dem DOD-Verfahren auch Wachs, Kunststoffe oder Lote als Druckmaterial verwenden, sodass damit sogar elektrische Schaltungen oder dreidimensionale Objekte gedruckt werden können.

Die verschiedenen Hersteller verwenden wiederum unterschiedlichste Bauweisen für ihre Druckköpfe und deren Drüsen, die allerdings hier nicht näher erläutert werden sollen. Allen gemeinsam ist allerdings, dass die Druckköpfe regelmäßig gereinigt werden müssen, da Tintenrückstände eintrocknen und so die Druckdrüsen verstopfen können. Um dies zu verhindern werden verschiedene Mechanismen angewandt. Beispielsweise wird der Druckkopf immer vor dem ersten Druckdurchlauf gereinigt. Andere Modelle verschließen den Druckkopf luftdicht, ähnlich der Kappe auf einem Füllfederhalter.

Tinte und Spezialpapiere

Wie bereits erwähnt sind Tintenstrahldrucker empfindlich gegenüber dem zu bedruckenden Papier. Erst auf Spezialpapieren erreichen sie ihre volle Qualität. Diese Papiere (die auch aus speziellen Kunststoffen bestehen können) unterscheiden sich in erster Linie in ihrer Struktur und der damit verbundenen Art und Weise, wie stark die Tinte innerhalb des Papiers verläuft.

Die meisten Tinten werden auf Wasserbasis hergestellt. Wichtig für CIJ-Drucker ist, dass die hier verwendete Tinte elektrisch leitend ist, da ansonsten der piezoeletrische Effekt nicht greifen kann und damit das gesamte Konzept des Tintenstrahldruckers hinfällig wird. Grundsätzlich unterscheiden sich die Tinten dadurch, ob die farbgebenden Stoffe in der Tinte gelöst sind (Farbstoffstinten) oder als Pigmente in der Tinte vorhanden sind (Pigmenttinten).

Der Laserdrucker – die moderne Alternative

Im Gegensatz zu Tintenstrahldruckern, bei denen das Druckverfahren bereits im Namen steckt, besagt das „Laser“ in Laserdrucker nicht, wie die Farbe auf das Papier gebannt wird. Vielmehr dient der Laser dazu, ein Abbild zu erstellen, mit dem dann die Farbe auf das Papier aufgetragen wird.

Aber der Reihe nach. Ein Laserdrucker zählt zu den sogenannten Seitendrucker, da die Belichtung der der Druck der gesamten Seite in einem einzigen Durchlauf geschehen. Er nutzt genauso wie Fotokopierer das Elektrofotografie-Prinzip.

Bei diesem Prinzip wird die Bildtrommel des Laserdruckers elektrisch aufgeladen. Dies geschieht bei älteren Modellen mittels einer sogenannten Ladekorona oder heutzutage mittels einer Ladungswalze, die die Bildtrommel direkt berührt und die elektrische Ladung direkt überträgt. Der große Vorteil des neueren Verfahrens ist, dass aufgrund der direkten Übertragung der Ladungen der Sauerstoff (O2) der Luft nicht mehr zu Ozon (O3) ionisiert wird und es damit weitaus umweltfreundlicher und weniger gesundheitsgefährdend ist.

Nach der Aufladung der mit einem Fotoleiter (sogenannte Phthalocyanine) beschichteten Bildtrommel erfolgt die Belichtung durch den namensgebenden Laser. Dort, wo das Licht des Lasers auf die Bildtrommel fällt, wird die Trommel wieder entladen. An diesen entladenen Stellen bleibt später der Toner hängen. Je stärker die Belichtung an einer Stelle ist, desto mehr Toner wird dort auch haften bleiben. Anschließend erfolgt die Entwicklung, bei der die auf der Bildtrommel verbleibende Ladung den Toner anzieht.

Im nächsten Schritt wird das zu bedruckende Papier zwischen die Bildtrommel und eine entgegengesetzt geladene Transferrolle gezogen. Die Ladung der Transferrolle zieht den Toner von der Bildtrommel zu sich hin, wodurch das Abbild, das im ersten Schritt auf die Bildtrommel aufgetragen wurde, nun in Form des Toners auf das Papier übertragen wird.

Nun muss das Tonerpulver noch fest mit dem Papier verbunden werden. Dies geschieht mittels Druck und Hitze (ca. 180 Grad Celsius) zwischen zwei weiteren Walzen. Dadurch verschmilzt der Toner mit dem Papier und das fertige Endprodukt wird ausgegeben.

Tintenstrahldrucker vs. Laserdrucker – was sind die Vor- und Nachteile?

Der Einfachheit halber sollen hier die Vor- und Nachteile eines Laserdruckers beschrieben werden – die Vorteile des Laserdrucks sind dementsprechend die Nachteile des Tintenstrahldrucks.

Die Vorteile eines Laserdruckers fangen bei bei der meist höheren Ausgaberate von bis zu 500 Seiten pro Minute an. Diese hängt natürlich stark vom jeweiligen Gerät ab. Bei reinem Textdruck und geschäftlichen Grafiken sind Laserdrucker in der Druckqualität unerreicht. Die gedruckten Konturen bluten nur gering aus und der Toner ist gegenüber Sonneneinstrahlung und Wasserkontakt beständiger als Drucke aus einem Tintenstrahldrucker. Weiterhin ist ein Laserdrucker weniger empfindliche gegenüber verschiedenen Papiersorten.

Neben diesen qualitativen Vorteilen weisen Laserdrucker auch rein praktische Vorteile auf. So sind beispielsweise die Druckkosten geringer, die Lebenserwartung der Gerät ist höher und der Wartungsaufwand fällt geringer aus, da die Tonerkartusche nicht verstopft, wenn längere Zeit nicht gedruckt wurde, wie es bei Tintenpatronen häufig der Fall ist.

Trotzdem gibt es natürlich auch einige Nachteile. So sind Laserdrucker für den Druck von Bilder nicht so gut geeignet. Zwar ist das Bild wischfest, allerdings nicht resistent gegenüber Knicken. Dabei können Teile des Toners sogar abblättern. Bei reinem Text ist dies nicht der Fall. Im Gegensatz zum Tintenstrahldrucker kann der Druckvorgang beim Laserdrucker nicht abgebrochen werden, da er wie bereits erwähnt zu den Seitendruckern gehört.

Beim Laserdruck kann die für das Verschmelzen des Toners notwendige Hitze ein Problem darstellen. So stellt das Bedrucken von Folien eine gewisse Herausforderung dar und benötigt Spezialfolien. Bei älteren Geräten mit einer Ladekorona entsteht zudem gesundheitsschädliches Ozon. Auch der Toner ist potenziell gesundheitsgefährdend und muss als Sondermüll entsorgt werden, was allerdings auch auf die Patronen eines Tintenstrahldruckers zutrifft.

Zusammenfassend lässt sich also sagen, dass vor allem beim Textdruck und Drucken im einfachen Büroumfeld Laserdrucker zu empfehlen sind, während Tintenstrahldrucker eher bei aufwendigen Bilddrucken ihre Vorteile ausspielen können. Da die meisten Drucker aber im Büro Verwendung finden und auch die meisten Kopierer mit Laserdrucktechnologie arbeiten, sind in diesem Bereich ebenfalls Laserdrucker beziehungsweise Multifunktionsgeräte zu empfehlen.

Probleme mit Ihrem Drucker?

Bei technischen Problemen mit Ihrem Drucker können wir Ihnen gerne weiterhelfen. Als IT-Dienstleister, gehört die Konfiguration, der Anschluss oder die Wartung ihrer Geräte wie Drucker zu unseren täglichen Aufgaben. Unsere zertifizierten IT-Spezialisten kümmern sich gerne um Ihr Problem!

Kontaktieren Sie uns noch heute!

Am 3. August 1984 wurde in Deutschland die allererste E-Mail empfangen. Verschickt worden war sie einen Tag zuvor in den Vereinigten Staaten von Amerika. Was damals über ein Vorläufersystem des Internets im Rahmen einer Kooperation zwischen amerikanischen und deutschen Universitäten verschickt wurde, hat bis zum heutigen Tag die Arbeitsweise der meisten Firmen revolutioniert. Was früher per Post und Telegramm mehrere Tage dauern konnte, wird heute in Sekundenbruchteilen abgearbeitet.

Während die E-Mail im Arbeits- und Privatleben mittlerweile nicht mehr wegzudenken ist, stellen mit der schieren Masse an versandten und empfangenen Mails immer größere Herausforderungen. Um diesen Datenmengen Herr zu werden gibt es einige ganze Reihe an Möglichkeiten, wie man diese archivieren kann. Dabei gilt es aber einiges zu beachten.

Wozu benötigt man eine E-Mail-Archivierung?

Seit die E-Mail die meisten anderen Kommunikationsplattformen wie Telefon, Fax und Post überholt hat, ist sie für die meisten Firmen absolut unabdingbar geworden. Jährlich werden Milliarden von Mails verschickt und mit ihnen Dokumente, Medien, Rechnungen und weiter Anhänge mehr. Diese sensiblen Dateien müssen alleine schon aus rechtlichen und steuerlichen Gründen regelmäßig und lückenlos archiviert werden.

Weiterhin sieht die Rechtslage in Deutschland vor, dass diese Daten manipulationssicher abgespeichert werden müssen. Das heißt, dass die enthaltenen Dokumente im Nachhinein nicht mehr verändert werden dürfen. Ähnliches gilt bereits für nicht-digitale Dokumente wie Rechnungen oder Urkunden.

Daneben gibt es auch rein praktische Gründe. So werden die Inhalte der E-Mails durch eine Archivierung vor Verlust geschützt. Die Archivierung dient also der Datensicherung. Über die verschiedenen Möglichkeiten einer Datensicherung im Allgemeinen können Sie in unserem Artikel dazu nachlesen.

Desweiteren kann durch eine Archivierung die Belastung des E-Mail-Servers reduziert werden, was gerade in großen Unternehmen mit einer enormen Anzahl an E-Mail-Accounts und versandten Nachrichten relevant ist.

Welche Arten der E-Mail-Archivierung gibt es und was unterscheidet sie?

Grundlegend kann man zwei Arten der Archivierung unterscheiden: die serverseitige und die clientseitige.

Bei ersterer Variante werden sämtliche eingehenden und ausgehenden Mails automatisiert archiviert. Dadurch werden sämtliche Mails und Dokumente manipulationssicher in das Archiv übertragen. Damit im Archiv selbst keine Manipulationen mehr möglich sind, müssen hierfür allerdings weitere Sicherheitsmaßnahmen getroffen werden. Diese Methode hat einen relativ hohen Speicherbedarf, weshalb eine gute Sortierung der Mails unabdingbar ist, damit beispielsweise keine großen Mengen an Spam-Mails mit archiviert werden.

Wichtig hierbei ist ein gut funktionierender Spamfilter, um zu verhindern, dass wichtige Daten aus Versehen gelöscht werden, die ungewollt als Spam markiert worden sind. Außerdem muss darauf geachtet werden, dass keine Mails archiviert werden, die aus rechtlichen Gründen nicht in das Archiv integriert werden dürfen. Dies ist aus datenschutztechnischen Gründen bei privaten E-Mails der Fall. Für diese Anforderungen werden meist serverseitige Konzepte angewandt, den Inhalt der Mails nach definierten Regeln analysieren und filtern, bevor sie archiviert werden. Diese Konzepte sind durch Softwarelösungen sehr gut an die individuellen Anforderungen der Firmen oder Privatpersonen anpassbar.

Ein weiterer Vorteil der serverseitigen Archivierung ist, dass das Suchen nach oder in älteren E-Mails nicht mehr über den E-Mail-Server laufen, sondern direkt im Archiv abgewickelt werden kann.

Die clientseitige Archivierung hingegen findet nicht automatisiert statt, sondern wird durch den Anwender direkt gesteuert. Dabei sortiert der User die E-Mails selbst und verschiebt sie manuell in das jeweilige Archiv. Dadurch bietet diese Methode einen hohen Grad an Flexibilität, allerdings birgt sie auch die Gefahr, dass relevante Mails aus Versehen archiviert oder gelöscht werden. Hierbei ist das menschliche Fehlerpotenzial recht hoch, während bei der serverseitigen Archivierung eher systematische Fehler auftreten können.

Gerade im geschäftlichen Bereich und bei großen Datenmengen ist also eine serverseitige Archivierung zu empfehlen, da hierbei einerseits Fehlerquellen minimiert werden und zum anderen eine rechtssichere Archivierung gewährleistet werden kann.

Mittlerweile gibt es eine ganze Reihe an Anbietern, die verschiedene Varianten der E-Mail-Archivierung anbieten. Application Service Provider (ASP) beispielsweise bieten E-Mail-Datenmanegement-Funktionen an, die keinerlei clientseitigen Programme erfordern und ausschließlich serverseitig arbeiten.

Stand-Alone-Lösungen hingegen sind Anwendungen, die sowohl client- oder serverseitig arbeiten können. Hierbei kann entweder der Anwender selbst entscheiden, welche E-Mails wie archiviert werden sollen oder er gibt Einstellungen vor, die dann vom Programm automatisiert befolgt werden.

Neben diesen Möglichkeiten der E-Mail-Archivierung gibt es auch einige Lösungen, die von Anbietern stammen, die bereits Dokumentmanagementsysteme oder CRM-Anwendungen (Customer Relationship Management) vertreiben. Diese Systeme arbeiten im Vergleich zu ASP-Lösungen umfangreicher und werden über eine clientseitige Anwendung verwaltet.

Isolierte Archivierung vs. E-Mail-Management

Die rein isolierte Archivierung von E-Mails steht immer wieder in der Kritik, da Bezüge zu anderen, relevanten Informationen oft nicht gewährleistet werden können. So sind die Inhalte von Geschäfts-E-Mails oft abhängig von vorausgegangen Besprechungen, die in einem Protokoll festgehalten worden sind. Da dieses Protokoll im Normalfall aber nicht immer im Anhang steht (bei größeren und längeren Projekten würde das den Umfang von Anhängen weit überschreiten), stehen die E-Mails für sich alleine und können nicht ausreichend in das Gesamtnetz an Informationen innerhalb einer Firma integriert werden.

Deshalb setzt sich immer das sogenannte E-Mail-Management durch, das den Sachzusammenhang zwischen den E-Mails und anderen elektronischen Dokumenten herstellen kann. Bei diesem Verfahren werden die Mails nicht in Abhängigkeit ihrer Form abgespeichert, sondern erfüllen auch andere Kriterien, beispielsweise die Speicherung nach Nutzen oder Rechtscharakter.

In diesen Managementsystemen werden die Mails an ein elektronisches Archivsystem übergeben, in der auch andere Datensätze (beispielsweise Besprechungsprotokolle) unter einem gemeinsamen Index („Tag“) gespeichert sind. Dadurch werden elektronische Akten erstellt, die ähnlich ihren haptischen Pendants funktionieren und verschiedenste Dokumente und Informationen enthalten können.

E-Mail-Archivierung und das Postgeheimnis

Aus rechtlicher Sicht gilt das Postgeheimnis auch für die elektronische Form von Briefen, also die E-Mails. Ein steuerlich relevantes Dokument (beispielsweise eine Rechnung) muss also auch in digitaler Form genauso dokumentiert und gesichert werden wie ein ausgedrucktes. Dies bedeutet, dass folgende Punkte erfüllt werden müssen:

Die archivierten E-Mails müssen dabei zu jeder Zeit erreichbar sein (beispielsweise bei einer Betriebsprüfung). Zu beachten ist, dass private E-Mails nicht automatisch archiviert werden dürfen, da dies gegen das Postgeheimnis (Grundrecht, Artikel 10) verstoßen würde. Hierfür können seitens des Arbeitgebers entweder ein allgemeines Verbot privater E-Mails eingeführt werden oder eine anderweitige vertragliche Vereinbarung dieses Problem lösen.

Probleme mit ihrer Archivierung? Wir helfen gerne!

Sollten Sie Hilfe bei Ihrer E-Mail-Archivierung oder generell bei einer Datensicherung benötigen, können Sie sich gerne jederzeit bei uns telefonisch oder per Mail melden und gemeinsam lösen wir Ihr Anliegen oder Problem!

Folgende Leistungen bieten wir Ihnen im Bereich der Datensicherung jederzeit an:

Sämtliche Vorgänge werden von unseren zertifizierten IT-Profis durchgeführt.

Sie brauchen für Ihr Unternehmen eine eigens für Sie zugeschnittene Software-Lösung im Bereich der E-Mail-Archivierung? Kein Problem! Wir beraten Sie gerne über die bestehenden Möglichkeiten.

In der heutigen Informationsgesellschaft werden Begriffe wie Privatsphäre, Datenschutz und IT-Sicherheit zu omnipräsenten Themen in sämtlichen Medien. Oft werden diese Begriffe fälschlicherweise synonym verwendet und stiften so zusätzlich Verwirrung. Wir klären auf über die wichtigsten Grundzüge der häufigsten Begriffe.

Was ist Datenschutz?

Der am häufigsten auftretende Begriff mag wohl der Datenschutz sein. Spätestens seit der Datenschutzgrundverordnung (DSGVO) hört man regelmäßig in den Nachrichten vom Datenschutz und Verstöße gegen eben jenen. Seit dem 25. Mai 2018 gilt in der gesamten Europäischen Union die sogenannte DSGVO – und damit auch in Deutschland. In dieser Verordnung ist im Grunde der „Schutz der Privatsphäre natürlicher Personen bei der Verarbeitung personenbezogener Daten“ geregelt.

Da die Datenverarbeitung in den letzten Jahrzehnten immer wichtiger und vor allem einfacher wurde, brauchen wir für deren Regelung zunehmend neue Richtlinien. In erster Linie dienen diese dazu, Organisationen wie Unternehmen (beispielsweise Google) daran zu hindern, eine Monopolstellung in Sachen Datennutzung aufzubauen und das Ausufern staatlicher Überwachung einzudämmen. Des Weiteren soll verhindert werden, dass die Entwicklung hin zum gläsernen Menschen weiter voranschreitet.

Die technische Entwicklung der letzten Jahre (vor allem des Internets) hat zum einen die zu verarbeitende Datenmenge in die Höhe schießen lassen. Dadurch sind Daten zum anderen aber auch zu einem gigantischen wirtschaftlichen Gut geworden und für Großkonzerne wie Google oder Apple von immenser Bedeutung.

Generell bezeichnet der Begriff Datenschutz also das Prinzip, natürliche Personen davor zu beschützen, dass ihre Daten gegen ihren Willen an Dritte weitergegeben werden.

Was sind Datensicherheit und IT-Sicherheit?

Als Datensicherheit bezeichnet man das rein technische Ziel, Daten vor ungewolltem Zugriff zu schützen und sie vor Manipulation und Verlust zu bewahren. Hierbei spielen soziale Faktoren noch keinerlei Rolle.

Die IT-Sicherheit beschreibt in erster Linie die technischen Komponenten von Datensicherheit und Datenschutz. Im betrieblichen Rahmen sorgt sie für den Schutz vor wirtschaftlichem Schaden, beispielsweise durch Hacker-Angriffe oder die ungewollte Verbreitung betriebsinterner Daten. In das Feld der IT-Sicherheit fällt aber auch Software wie die Firewall oder der Virenscanner eines Computers. Bei der IT-Sicherheit spielen soziale Faktoren bzw. der Mensch eine wichtige Rolle. Beispielsweise berücksichtigt die IT-Sicherheit wenn möglich auch das potenzielle Verhalten der Nutzer.

In Abgrenzung dazu werden zur Informationssicherheit auch diejenigen Informationen gezählt, die nicht elektronisch verarbeitet werden, beispielsweise Handschriftliche Dokumente, die ebenfalls personenbezogene Daten beinhalten können.

Was muss ich beim Thema Datenschutz beachten?

Generell besagt die Informationelle Selbstbestimmung, dass jeder Mensch ein Recht darauf hat, selbst darüber zu entscheiden, was mit seinen personenbezogenen Daten geschieht und wer sie erhält. Daraus folgt im Prinzip, dass man personenbezogene Daten anderer Menschen nicht ohne die Einwilligung der jeweiligen Person an Dritte weitergeben werden dürfen. Genau genommen fängt dies bereits bei der privaten Telefonnummer des Freundes an, die man an ohne dessen Einwilligung an einen anderen Freund weitergibt.

Dies ist natürlich die rein rechtliche Bestimmung. Dass dies in der Praxis oft bei weitem nicht so eng gesehen wird – vor allem im privaten Bereich – ist verständlich. Aber gerade, wenn Firmen und damit große Geldmengen ins Spiel kommen, sollte man Vorsicht walten lassen. Denn generell kann man zur Rechenschaft gezogen werden, sollte man personenbezogene Daten Anderer an Dritte weitergeben.

Jeder hat das Recht, selbst darüber zu entscheiden, wie er mit seinen persönlichen Daten umgehen möchte. Ob man persönliche, möglicherweise pikante Informationen frei im Internet zirkulieren lassen möchte, muss jeder selbst entscheiden. Heutzutage ist es kein Einzelfall mehr, dass die Personalchefs von Firmen die sozialen Netzwerke ihrer potenziellen neuen Mitarbeiter genauer unter die Lupe zu nehmen. Auch wenn diese Informationen die Entscheidung der Personaler eigentlich nicht beeinflussen darf, kann man trotzdem davon ausgehen, dass sie es (wenn auch unterbewusst) tun.

Allgegenwärtig ist auch die empfundene Gefahr einer flächendeckenden Überwachung und Ausspähung durch den eigenen Staat, wie es bereits in den Vereinigten Staaten Gang und Gäbe ist. In Deutschland sieht die rechtliche Lage allerdings ein wenig anders aus. Aufgrund der Gewaltenteilung braucht es für jede ausspähende Maßnahme seitens des Staates einen richterlichen Beschluss. Die dadurch erfassten Daten und Informationen dürfen nicht auf Vorrat gespeichert werden, sondern nur in einem begründeten Verdachtsfall. Außerdem muss der Ausgespähte nach einer Frist darüber in Kenntnis gesetzt werden, dass er überwacht wurde.

Tipps zum sicheren Verhalten im Internet

Das persönliche Engagement spielt bei der Sicherheit ihrer Daten eine enorme Rolle, da sich Firmen, die Ihre Daten erlangen wollen, um sie gewinnbringend weiterverkaufen zu können, sich selbst absichern, um nicht gegen Ihr Grundrecht der Informationellen Selbstbestimmung zu verstoßen. So akzeptieren Sie durch das Annehmen einer Softwarelizenz (beispielsweise bei Windows), dass eine ganze Reihe an personenbezogenen Daten an die Herstellerfirma gesendet wird. Verweigern Sie diese Zustimmung, dürfen Sie das Produkt auch nicht verwenden.

Die Tendenz, in solchen Fällen mit unseren personenbezogenen Daten für Lizenzen und Dienstleistungen zu bezahlen wird immer stärker und ist in hohem Maße besorgniserregend, wenn auch in der heuten Informationsgesellschaft kaum mehr aus der Welt zu schaffen.

Abschließend lässt sich sagen: seien Sie sich der eigenen Verantwortung gegenüber Ihren personenbezogenen Daten bewusst und gehen Sie nicht zu sorglos mit diesen um! Man muss zwar nicht in Paranoia verfallen, allerdings ist eine gewisse Vorsicht definitiv geboten.

Im letzten Teil unserer Artikelserie behandeln wir die HDMI-Schnittstelle und sehen uns genauer an, was Bezeichnungen wie HD, UHD und HD Ready bedeuten.

Die HDMI-Schnittstelle wurde bereits Ende 2002 in ihrer ersten Version veröffentlicht. Heute finden sie HDMI-Anschlüsse an den meisten Endgeräten, vor allem aber an Desktop-PCs, Laptops, Spielekonsolen und Home Entertainment Systemen. Während sich der ebenfalls digitale Display Port Standard vor allem auf dem stationären Computermarkt etabliert hat, ist HDMI bei Unterhaltungselektronik vertreten.

HDMI unterstützt – wie die anderen modernen Videosignalstandards auch – nicht nur die Videoübertragung, sondern setzt auf eine ganze Bandbreite an möglichen Informationskanälen. So werden neben dem Bildsignal bis zu 32 Audiokanäle, Kopierschutzmechanismen (DRM) und teilweise sogar Ethernet unterstützt.

Mit der 2017 vorgestellten aktuellen Version 2.1 lassen sich Auflösungen von bis zu 8K (7680 × 4320 Pixel) bei 60 Hz Bildwiederholrate oder 4K (3840 × 2160 Pixel) bei 120 Hz erreichen. Letzteres erlaubt das Abspielen von 3D-Material in 4K-Auflösung.

Neben dem normalen HDMI-Stecker gibt es noch die beiden kompatiblen Varianten MiniHDMI und MicroHDMI, die aufgrund ihrer kompakteren Bauweise vor allem für mobile Endgeräte verwendet werden.

HD (kurz für High Definition) bedeutet im Grunde nichts anderes als „hohe Auflösung“. Mit dieser Abkürzung werden mittlerweile eine ganze Bandbreite an verschiedenen Begriffen zu Werbezwecken und Gerätebeschreibungen verwendet. Wir erklären die wichtigsten und am weitesten verbreiteten Beschreibungen.

HD-Auflösungen = setzen eine minimale Zeilenanzahl von 720 Pixeln voraus. Bei einem Seitenverhältnis von 4:3 entspricht die Spaltenanzahl 960, bei 16:9 sind es 1280 Pixel.

Full-HD = entspricht einer Auflösung von 1920x1080 Pixeln (1080p).

UHD 4K = entspricht einer Auflösung von 3840x2160 Pixeln. Da die Anzahl von Zeilen und Spalten im Vergleich zu Full-HD jeweils verdoppelt werden, ist die Pixelanzahl vervierfacht.

UHD 8K = entspricht einer Auflösung von 7680x4320 Pixeln. Im Vergleich zu Full-HD wird die Pixelanzahl versechzehnfacht.

Das Siegel HD Ready kann jeder Hersteller für seine Geräte lizenzieren, die mindestens eine Auflösung von 1280 × 720 Pixeln (720p) verarbeiten können.

Darauf aufbauend wurde 2007 das Siegel HD Ready 1080p bereitgestellt, das zusätzlich zu den Voraussetzungen von HD Ready eine höhere Auflösung von mindestens 1920x1080 Pixeln bietet (was der Bezeichnung Full-HD entspricht).

Hiermit endet unsere vierteilige Artikelserie zu Videokabeln. Im Folgenden finden Sie noch einmal die anderen Teile der Serie:

Übersicht

In den beiden vorangegangen Artikeln dieser Reihe haben wir bereits einen Überblick über die einzelnen Videokabel geben und sind genauer auf die beiden etwas älteren Video-Standards VGA und HDMI eingegangen. Im heutigen Artikel geht es um die moderneren Standards Display Port und die Multifunktionsschnittstelle Thunderbolt von Apple.

Ähnlich wie HDMI oder Thunderbolt bietet der 2006 eingeführte Standard Display Port die Möglichkeit Bild und Ton über ein Kabel zu übertragen, statt mehrere zu verwenden.

Seit circa 2016 hat der Display Port den alten Standard DVI abgelöst. Vor allem im Computerbereich, wo Monitore an die Grafikkarten der Rechner angeschlossen werden, hat sich der Display Port durchgesetzt, da er einige Vorteile gegenüber der Konkurrenz HDMI aufweist.

So bietet der Display Port beispielsweise die Möglichkeit sogenannte Daisy Chains einzurichten. Hierbei werden kompatible Monitore in Reihe geschaltet und können unabhängig voneinander angesteuert werden. Vergleichbares ist mit der HDMI-Schnittstelle nicht möglich, hierfür bräuchte man mehrere Anschlüsse, die parallel geschaltet werden.

Ein weiterer Vorteil des Display Ports ist, dass er im Vergleich zu den älteren Standards VGA und DVI eine weitaus kleinere Steckerbuchse hat, was vor allem für mobile Endgeräte wie Laptops von Vorteil ist, da diese in den letzten Jahren kleiner und vor allem dünner geworden sind.

Im Gegensatz zu HDMI und Thunderbolt besitzt der Display Port eine Verriegelungsmechanik.

Apple versucht seit 2011 mit seiner Thunderbolt-Technologie die eierlegende Wollmilchsau unter den Datenkabeln zu erschaffen – und dies gelingt dem Technologiekonzern aus Kalifornien recht gut.

Die Thunderbolt-Schnittstelle vereint Video-, Audio- und Datenübertragung sowie Peripherie in einer Schnittstelle. Technisch gesehen ist es eine Weiterentwicklung der Display Port Technologie, weshalb er zu verschiedensten anderen Kabeltypen (u.a. USB, HDMI, DP, DVI, VGA) kompatibel ist. Da Thunderbolt auch zur Energieübertragung dient, können damit beispielsweise kompatible Smartphones und andere Geräte geladen werden.

Da Thunderbolt auf dem USB Type C Stecker basiert, ist die Buchse – im Gegensatz zu älteren USB-Varianten – punktsymmetrisch, wodurch die Einsteckrichtung nicht mehr relevant ist. Durch die kompakte und kleine Bauweise und dadurch, dass viele Funktionen in einem Stecker vereint werden, eignet sich Thunderbolt vor allem für mobile Endgeräte.

Nachdem Anfang 2019 die Lizenzen für Thunderbolt an das USB Implementers Forum (USB-IF) übergeben worden wird, ist Thunderbolt lizenzfrei erhältlich. Im gleichen Zuge wurde angekündigt, dass der zukünftige USB 4 Standard auf Basis von Thunderbolt 3 entwickelt werden wird.

Im vierten und letzten Teil unserer Serie werden wir das High Definition Media Interface (HDMI) behandeln und genauer die verschiedenen Bezeichnungen HD Ready und Full HD eingehen.

Vermutlich sind auch Sie einer der vielen Nutzer, die mit den Microsoft Office Produkten aufgewachsen sind. Word ist das Tool, wenn es um Textverarbeitung geht. Irgendwann im Büro, hat man früher oder später Berührungspunkte mit den Microsoft Softwareprodukten.

Die Word Dateiendungen wie .doc oder .docx haben vermutlich von Ihnen viele bereits gesehen oder es kommt Ihnen bekannt vor. Aber wussten Sie, dass sich hinter diesen Dateiformaten nicht nur harmlose und tolle Texte verbergen können, sondern auch Trojaner und Viren? Durch die Office-Funktion „Makros“, ist es möglich, innerhalb der Produktenfamilie von Microsoft bestimmte menschliche Routineaufgaben zu automatisieren.

Makros sind kleine „Computerprogramme“, welche aktiviert werden können, wenn Sie z.B. ein Word Dokument öffnen. Sobald Sie die Rohdatei von Word öffnen, dann haben Sie immer eine eingeschränkte Ansicht und manchmal werden notwendige und gewünschte Felder und Funktionen nicht korrekt angezeigt. Indem Sie die Makros aktivieren, haben Sie dann den vollen Funktionsumfang. Sie erhalten dadurch die komplette Ansicht, die der Absender des Dokuments zuletzt abgespeichert hat. Dies sind auch die Vorteile von Word-Dokumenten. Sie können da weiterarbeiten, wo Ihr Gegenüber aufgehört hat, und können Dokumente nach Ihren Wünschen und Anforderungen anpassen. Sie haben immer die Rohdatei, damit Sie dann flexibel Änderungen zu jeder Zeit vornehmen können.

Indem Sie jedoch die Aktivierung von Makros zulassen, erlauben Sie auch der Anwendung weitgehende Rechte für ihr System. Viele Betrüger nutzen die Gutgläubigkeit der Nutzer aus und schleusen so Schadcode auf den Computer. Mittels Javascript werden dann weitere schädlichen Programme aus dem Internet auf Ihr Computer heruntergeladen. Ihr PC ist dann derart kompromittiert, dass ein weiteres Nutzen nicht mehr zu empfehlen ist. Die Schadsoftware verbreitet sich meistens zusätzlich im eigenen Netzwerk, sodass alle Ihre Computer mit dem Trojaner befallen sein können. Es ist deshalb darauf zu achten, schnell zu handeln und keine Zeit zu verlieren. Nehmen Sie am besten komplett Ihren Router vom Strom und ziehen Sie die Stromkabel der betroffenen Computer. Fahren Sie die Computer ausnahmsweise nicht herunter, da die Verschlüsselung meistens größtenteils beim Herunter- bzw. Hochfahren erfolgt.

Seitdem Verschlüsselungstrojaner immer mehr in den Focus geraten sind und sich für die Betrüger als lukrativ erwiesen haben, ist davon eher auszugehen, dass Sie nicht nur einen Trojaner einholen, sondern eher einen Verschlüsselungstrojaner. Ihre Daten werden dann unwiderruflich verschlüsselt und das Zahlen des Lösegeldbeitrags hilft Ihnen da auch wenig. Erstens können die Betrüger die Zahlung nicht an den entsprechenden Opfer zuordnen und zweites unterstützen Sie dadurch der dubiosen Geschäftspraktik der Hacker.

Als Nutzer können Sie sich damit intensiver beschäftigen und so ihre Kollegen über das Thema sensibilisieren. Leider gibt es hier kein klassisches Rezept, wie Sie sich am besten davor schützen. Im Zweifel sollten Sie niemals unbekannte Anhänge öffnen und schon gar nicht Makros aktivieren. Leider gehen die Betrüger professioneller voran als in den letzten Jahren. Es werden E-Mails von realen Personen verwendet, mit denen man eine E-Mail Verkehr hatte. Dadurch können auch erfahrene und technikaffine Personen, mit erhöhtem Selbstbewusstsein, dazu verleitet werden, reflexartig, Anhänge zu öffnen. Darüber hinaus werden die Schreiben so gut in echtem Deutsch verfasst, dass es nicht sofort ersichtlich für den Anwender ist, dass es sich hierbei um eine gefälschte E-Mail handelt.

Die neueren Office Pakete sind zwar besser geschützt, da die bekannten Software-Schwachstellen bereits geschlossen wurden. Jedoch werden Lücken nicht immer sofort gepatcht und veröffentlicht. Viele Nutzer benutzen noch alte Versionen von Microsoft Office und sind sich den Gefahren nicht bewusst. Ebenfalls werden ständig neue Bugs gefunden, sodass Sie nie sicher davon ausgehen können, dass es Sie nicht betreffen könnte. Achten Sie darauf, dass Sie stets die neuesten Aktualisierungen auf Ihrem Computer haben und überprüfen Sie regelmäßig Office-Updates.

Fazit: Auch wenn es altbekannte Techniken sind um den Nutzern einen größtmöglichen Schaden anzurichten und Profit rauszuschlagen, können Sie mit einfachen Mitteln z.B. mit unserer Checkliste Ihre Sicherheit steigern.

• Installieren Sie einen guten Virenscanner

• Machen Sie regelmäßig Updates von ihrem Betriebssystem

• Überprüfen und Aktualisieren Sie alle ihre Anwendungen wie Office

• Seien Sie misstrauisch bei Makros in Office-Dokumenten

• Lassen Sie ihre Dokumente immer als erstes scannen bevor Sie sie öffnen

Heutzutage funktioniert nichts ohne eine vernünftige IT. Ohne die IT sind viele Firmen aufgeschmissen und können nicht mehr arbeiten. Durch die Digitalisierung wird dieser Trend immer weiter vorangetrieben. Die IT ist da, damit ein produktiveres und effizienteres Arbeiten möglich ist. Es steigert in allen Bereichen unsere Lebensqualität.

Die Informationstechnologie ist mittlerweile so stark in unserem Leben präsent und ausgeprägt wie nie zuvor. Es beeinflusst anhand von Algorithmen unsere Kaufentscheidungen, unsere Smartwatch misst unseren Puls und gibt Warnungen aus, wenn etwas außergewöhnliches passiert. Durch die IT, werden Kampfdrohnen gesteuert und es dient auch dazu da, um den medizinischen Fortschritt zu unserem Nutzen zu machen. Krankheitsbilder können durch die IT schneller erkannt werden und es können entsprechende Maßnahmen getroffen werden. Die IT ist für den Tod von Millionen von Menschen verantwortlich, aber zugleich auch für den Erhalt des Lebens von Millionen von Menschen. So wie die IT für schlechte Absichten genutzt werden kann, so kann diese auch für gute Zwecke genutzt werden. Das Vertrauen in den guten Menschen, haben sich vermutlich auch deshalb, viele schon für sich selbst abgeschrieben.

Fremden sollte man nicht vertrauen und warum auch? Wenn alleine die Politik und die Menschheit in allen Punkten im gesamten, versagt hat? Schnell erkennt man, dass Vertrauen nicht von heute auf morgen entsteht, sondern dies eine langwierige Sache darstellt. Vertrauen ist ein Prozess, welches Jahre benötigt. Je länger man sich in bestimmten Bereichen des Lebens bewiesen hat, desto mehr Vertrauen gewinnt man von den Menschen in seiner Umgebung. Dieser Vertrauensprozess kann zwar beeinflusst werden, um schneller den Status von seinen Mitmenschen zu erhalten. Wenn man mal etwas verbrochen hat, dann ist, das mühsam erarbeitete Vertrauen und das Ansehen, nachhaltig geschädigt.

Was wollen wir Ihnen damit sagen? Dieses Schema des Vertrauens, lässt sich auf alle Bereiche des Lebens anwenden, so auch in der IT. Würden Sie jedem Zugang in Ihre eigenen Daten gewähren? Vermutlich würden Sie dies nicht einfach so unbegründet machen. Manchmal ist man gezwungen sich einem IT-Dienstleister seine Daten anzuvertrauen, weil man beispielsweise eine Datenwiederherstellung haben möchte, oder das eigene System nicht mehr hochfährt. Was tun bei einer Malware-Infektion ihres Computers? Spätestens dann, werden Sie einen guten IT-Spezialisten konsultieren. Von banalen IT-Problemen bis hin zu komplexen Problemen, früher oder später, werden Sie nicht drum herum kommen Hilfe herzuholen, damit Sie ihre Probleme in den Griff bekommen.

Es stellt sich die Frage, was mit den eigenen Daten passiert? Man will gar nicht an so eine Situation denken und in Erwägung ziehen. Jedoch kann das Mal schnell passieren, dass man in so eine hilflose Situation kommt. Insbesondere mit dem Zeitalter des Internets sind alle Nutzer Opfer der großen Tech-Konzerne geworden. Es werden Daten gekauft und Profile erstellt. Werbekunden werden diese Profile als einstellbare Parameter zur Verfügung gestellt, womit man dann eine gewünschte Zielgruppe für seine Produkte ansprechen kann. Umso mehr sollte man aufpassen, damit die eigenen Daten nicht jeder erhält. Auch in diesem Beispiel erkennt man recht deutlich, wie wichtig das Vertrauen in Firmen ist. Letztendlich sind Sie durch ihre Daten auf ihrem Computer ein gläserner Mensch. Nicht jeder ist bereit, alles von sich preiszugeben.

Wo liegt das Problem, dass man ein gläserner Mensch ist? Manchmal erklären uns Kunden, dass man doch nichts zu verheimlichen hat. Es kann im gewissen Maße stimmen, jedoch hat jeder Mensch eine Privatsphäre, welche geschützt gehört. Ist es nicht erschreckend, wenn Sie von Amazon erfahren müssten, dass Sie oder Ihre Frau vielleicht schwanger sind? Einfach aufgrund Ihres Kaufverhaltens. Indem Sie bestimmte Lebensmittel-Produkte kaufen, kann Amazon anhand dieser aufgezeichneten Werte ermitteln, wie wahrscheinlich es ist, dass sich Ihre Geschmäcker für bestimmte Produkte geändert haben. Daraus lässt sich ein ziemlich gutes Bild erstellen, ob Sie schwanger sind und dies erfahren Sie als erstes von einem IT-Konzern und nicht von einem Arzt. So wie Sie darauf achten, dass Ihre Haustüre immer abgeschlossen ist, so sollten auch Sie einen Riegel vor Fremden schieben, damit Ihre Daten immer bei Ihnen bleiben. Auch wenn Daten kontinuierlich im Netz gesammelt werden, sollten Sie die Initiative ergreifen und danach streben, dass Ihre Daten behutsam und sorgfältig aufbewahrt werden. Machen Sie von Ihren Rechten Gebrauch und holen Sie Auskunft über die gespeicherten Informationen und über die Weitergabe Ihrer Daten.

Der Erwerb des Vertrauens in IT-Partner ist eine sehr lange und schwierige Strecke. Indem Sie Zugriff auf Daten, Systeme, Backups und Datenbanken gewähren, können diese schnell missbraucht werden. Es kann für den einen oder anderen beängstigend sein, alle Firmengeheimnisse auf einen Schlag preisgeben zu müssen. Schließlich könnte man anhand dieses Wissens Ihnen Konkurrenz machen und ihr hart erarbeitetes Firmenwissen, gegen Sie verwenden.

Wir sind diesen Problemen und dieser Skepsis bewusst. Wir unterschreiben deshalb auch immer eine Vertraulichkeitserklärung, damit Sie sich auf uns verlassen können. Wir nehmen die Sicherheit ihrer Daten sehr ernst, sodass keine Informationen nach außen gelangen. Als IT-Systemhaus sehen wir es in unserer Verpflichtung, Ihnen den bestmöglichen Schutz vor Hacker-Angriffen zu geben und damit das Firmenwissen nie abhandenkommt. Gemeinsam können wir ein Konzept entwickeln, sodass Firmeninterna nie das Haus verlassen.

Wir bieten als IT-Dienstleistungsunternehmen, eine enge und langfristige Zusammenarbeit an. Wir wissen ganz gut, wie wichtig das Vertrauen in der IT und der eigenen Partnerfirmen ist. Ohne Vertrauen ist ein Fortschritt nicht möglich. Im IT-Sektor haben wir bereits tausende Kunden bedient und haben hierbei hervorragende Referenzen erzielt. Das gegenseitige Vertrauen ist nicht käuflich zu erwerben, sondern entwickelt sich mit der Zeit. Geben Sie uns die Chance uns bei Ihnen als einen guten und zuverlässigen IT-Dienstleister zu erweisen.